大家好,欢迎收听本期节目。今天,我们将一起走进 HyperAttention 的奇妙世界,了解这种全新近似注意力机制如何让大型语言模型在长上下文下也能飞速推理。

什么是 HyperAttention?

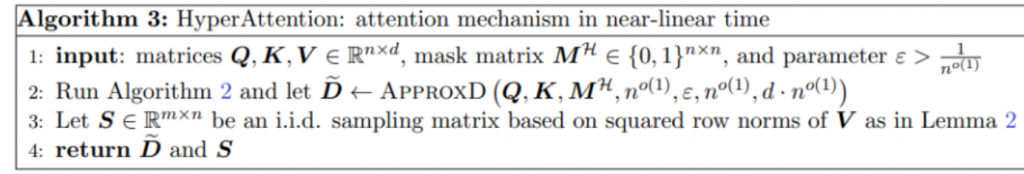

HyperAttention 是一种近似注意力机制,它可以显著提升大型语言模型在长上下文下的推理速度。传统的注意力机制在计算时需要遍历整个输入序列,这使得计算成本非常高。而 HyperAttention 则通过对注意力矩阵进行近似,从而大幅降低计算成本。

HyperAttention 的工作原理

HyperAttention 的工作原理并不复杂。它首先会对注意力矩阵进行分解,然后对每个子矩阵进行近似。最后,将所有子矩阵的近似结果组合起来,得到最终的注意力矩阵。

HyperAttention 的优势

HyperAttention 的优势非常明显。它可以显著提升大型语言模型在长上下文下的推理速度,同时还能保持较高的准确率。在某些情况下,HyperAttention 甚至可以将推理速度提升 50% 以上。

HyperAttention 的应用

HyperAttention 可以广泛应用于各种自然语言处理任务,如机器翻译、问答系统、文本摘要等。它可以帮助这些任务在处理长上下文数据时获得更高的效率和准确率。

HyperAttention 的未来

HyperAttention 是一种非常有潜力的近似注意力机制,它有望在未来得到更广泛的应用。随着研究的不断深入,HyperAttention 的性能还将进一步提升,从而为大型语言模型的应用开辟新的可能性。

论文: https://arxiv.org/pdf/2310.05869.pdf

论文: https://arxiv.org/pdf/2310.05869.pdf