在浩瀚的数字宇宙中,智能系统正以前所未有的速度重塑我们的世界。传统大模型固守内部思维链条(Chain-of-Thought,简称CoT),尽管已能模拟人类一段段推理过程,但当面对复杂计算、冗长推理以及思维幻觉(hallucinations)的困扰时,内部「独角戏」显得孤掌难鸣。本文将带您探寻一项颠覆性技术——START(Self-Taught Reasoner with Tools),一个自我教化、工具整合的长链推理大模型,它不仅接轨代码执行、自动自省,还通过「Hint-infer」、「Hint-RFT」等创新框架实现自我增强。让我们一步步揭开这一智能模型的神秘面纱,探索其如何将内部思维与外部工具无缝结合,从而突破推理瓶颈、降低幻觉风险,并在数学、物理、编程等多维领域展现突破性表现。

🌌 开启智能工具整合之旅

传统大模型在复杂任务上的表现一直备受关注。以长链思维(Long CoT)为核心的推理方法,曾让模型仿佛展开了一场场无限延展的逻辑对话。然而,这种仅依赖内部运算的方式,往往会受到思维幻觉与计算不准的制约——正如一位诗人在漫长独白中终究会出现逻辑误区一样。

START 的问世,在于认识到:人类在解决问题时,并非单打独斗,而是借助外部记事本、计算器和草稿纸,不断校正和反思。我们是否也能赋予大模型这种自我辅助能力?答案是肯定的。通过将 Python 等外部工具引入推理过程中,START 成功实现了工具辅助推理(Tool-Integrated Reasoning,TIR),有效遏制了幻觉现象,同时大幅提升了模型在复杂计算、代码调试等任务中的准确性。

在论文中,作者明确指出,传统的长链思维在遇到复杂情形时,往往「闭门造车」,导致生成错误答案。而 START 则巧妙地将外部工具调用嵌入推理过程中,使模型能够自我检查、调试并反馈结果,从而极大改善了推理过程。

🔍 切入核心:长链 CoT 与工具调用的协同效应

长链思维(CoT)方法是一种通过多个中间步骤来解决问题的策略,它揭示了问题结构,并使模型能够逐步达成正确结论。然而,内部推理链条「过长」时,模型容易陷入局部最优、信息衰减甚至幻觉困境。START 从根本上打破了这一壁垒,其核心理念在于将大模型的内在思考与外部工具的精确执行相融合。

论文的核心创新主要体现在两个方面:

- Hint-infer: 在模型的推理过程中,适时地向模型注入「提示」(hints),例如「等等,也许用 Python 是个好主意。」这些提示不仅能在关键节点刺激模型调用代码解释器,还能在模型内部形成一种自我质疑和校正的机制。通过这种简单而巧妙的方式,模型能够实时调用工具,进行复杂运算和结果验证。

- Hint Rejection Sampling Fine-Tuning(Hint-RFT): 此技术将 Hint-infer 与拒绝采样(rejection sampling)策略相结合,对生成的推理轨迹进行评分、过滤和修改,进而进行微调(fine-tuning)。同时,基于自我蒸馏(self-distillation)的数据生成,进一步扩展和多样化模型的工具调用表达能力。这一层次的精细调优,使得模型在面对从数学问题到程序调试多种任务时,都能展现出更高的准确率。

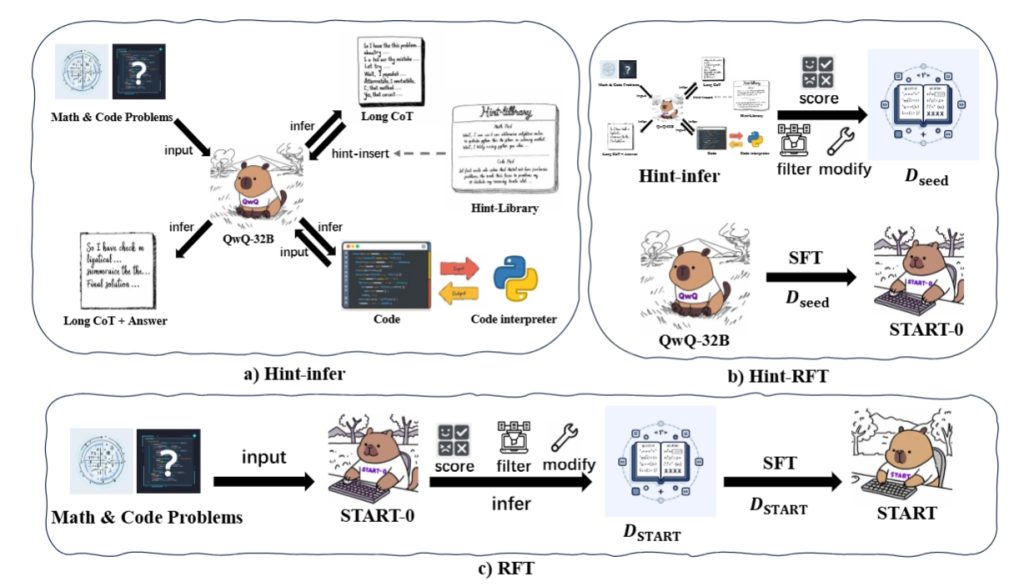

正如论文中Figure 1所示,整个训练框架分为两大阶段:Hint-RFT 阶段和随后的 RFT 阶段。模型最初通过 Hint-infer 生成的轨迹构造了初步种子数据($D_seed$),再利用拒绝采样产生更具多样性和准确性的 $D_START$ 数据集,最终将基础模型 QwQ 微调为极具竞争力的 START。

🧬 Hint-infer:启发式提示引导的奇妙之处

在 START 的设计中,「Hint-infer」 扮演着启示剂的角色。其实质就是在模型推理过程中注入预设的提示,以激活其对外部工具(如 Python 代码解释器)的调用能力。与直接提示模型「写代码」、「执行代码」相比,这种插入提示策略更为微妙且有效。

论文中提到,在数学推理任务中,简单提示「等待,我可以用 Python 来验证答案」即可激励模型生成正确代码,而在面对更复杂的编程任务时,则需要精细设计的代码模板与提示协同激活调试流程。这种提示不仅极大地扩展了模型思考的通道,也使得模型在长链思维中具备了类似于人类思考时使用辅助工具的「外在记忆」。

论文展示了各种不同功能的提示,如用于调试的「Debug hint」和针对不同领域的领域专用提示。这些提示像一把把钥匙,帮助模型在遇到知识盲区时迅速跳转到工具调用通路,从而顺利完成验证和修正。提示的设计还考虑了关键节点的插入时机,比如在连接词「Alternatively」和「Wait」处,它们往往暗示着模型开始考虑替代方案或自我反思,这时恰好插入提示信息能够发挥最佳效果。

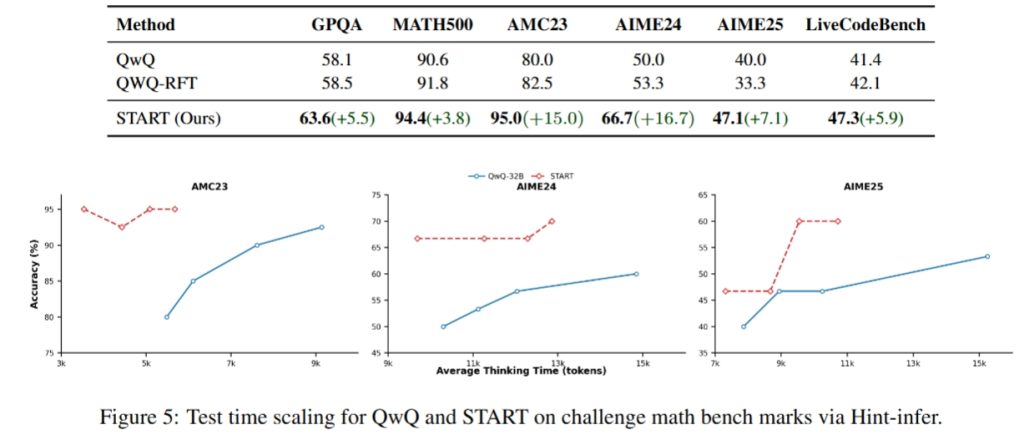

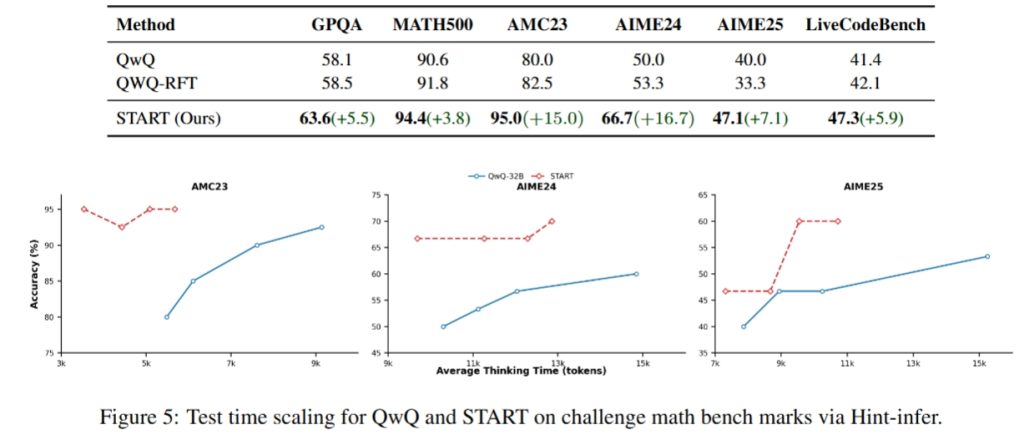

同时,论文中提到,将提示插入长链推理的末尾,不仅增加了模型的「思考时间」,还能实现一种「顺序测试时间缩放」的效果(sequential test-time scaling),即随着提示插入轮次增加,模型的成功率呈现出稳步上升的趋势(详见图5)。

⚙️ Hint-RFT:自我训练与精细调优的双重奏

在 Hint-infer 的基础上,作者进一步提出 Hint-RFT 框架,旨在通过「评分-过滤-修改」方法,大幅提升模型工具调用的潜在能力。具体过程可以类比于一位自我复盘的优秀学生:在每次解题后,他会通过自我检查、比较答案、修改错误,从而不断进步。Hint-RFT 即是在这一过程中引入的自动「自我训练」机制。

Hint-RFT 的运作流程如下:

- 评分与过滤: 收集由 Hint-infer 生成的初步推理数据,并根据规则对推理轨迹进行评分,过滤掉重复或不合理的部分。

- 修改与精调: 对筛选后的数据进行内容修改,使得推理过程更符合工具调用的准确范式。

- 自我蒸馏: 以 START-0 作为基准,通过多轮采样和拒绝采样生成更多样本(构成数据集 D_START),利用这些数据对模型再次微调。

这种自我教化的策略,使得 START 不仅在数学和科学问答、编码挑战中实现了显著性能提升(在 GPQA、AMC23、AIME24、AIME25 和 LiveCodeBench 等重要基准上的表现均优于传统 QwQ 模型),还通过工具整合,将内在推理与外部调用有机结合,治愈了传统长链推理中的短板。

实际上,Table 1 在论文中清晰列出了各种模型在不同基准下的表现。可以看到,START 在数学和代码任务上分别超越了 15% 到 16.7% 的绝对提升,这无疑证明了引入 Python 工具调用的巨大效用。

📊 实验与对比:数据背后的真知灼见

实验部分是衡量创新是否成功的试金石。论文中设计了一系列具有挑战性的任务,涵盖博士级别的科学问答(GPQA)、高中数学、数学竞赛(AMC23、AIME24、AIME25)以及编程题(LiveCodeBench)。各项指标均采用 Pass@1,即第一答案正确率进行评估。

下表摘自论文(经过适当改写)展示了部分关键数据:

| 方法 | GPQA | MATH500 | AMC23 | AIME24 | AIME25 | LiveCodeBench |

|---|---|---|---|---|---|---|

| QwQ | 58.1 | 90.6 | 80.0 | 50.0 | 40.0 | 41.4 |

| QwQ-RFT | 58.5 | 91.8 | 82.5 | 53.3 | 33.3 | 42.1 |

| START (本模型) | 63.6 | 94.4 | 95.0 | 66.7 | 47.1 | 47.3 |

由上表可知,START 模型在所有指标上均实现了显著提升。特别是在 AMC23 与 AIME 系列比赛题中的跨越式进步,充分说明了工具整合在提升数学与逻辑推理中的不可替代作用。此外,基于 Hint-infer 的测试时间缩放实验(如图5所示)证明,随着插入提示轮次的增加,模型的成功率呈现稳定上升的趋势,这也为未来如何进一步优化推理过程提供了理论支持。

在医学、天文等高精尖领域,一项技术的推广不仅仅依赖于其原理的创新,更体现在实际任务中的优异表现。START 利用工具调用后的「自我调试」能力,正如人类专家在计算机辅助下能更准确地匹配复杂公式一般,极大提升了应对高难任务的效率和准确性。

🧪 数学与代码:案例深度解析

论文还附带了多个案例研究,深入展示了 START 模型在数学与编程题目中的实际应用。这些案例不仅是数理逻辑的演练,更好比一场思想的角力,让人能够直观感受到模型「自我教化」的魅力。

案例 1 —— AMC23 数学题

题目描述了一个货币问题,要求找出无法用面值为 6、10 与 15 分的硬币组成的最大金额,并求其数字之和。传统方法需要穷举、计算,而 START 模型则通过调用 Python 解释器端对代码执行进行自我反馈,不仅精确地计算出结果 29(数字之和为 11),还展示了推理和调试过程的闭环机制。

关键公式:

对于不定方程求解,模型内部实际构造了如下形式:

经过多重调试,模型判断当 $x=29$ 时无解,便得出答案。

案例 2 —— AIME24 与 AIME25 编程题

在另一组案例中,模型需要在给定条件下找出满足特定模运算关系的最小整数,通过提示插入和代码调用,模型首先在内部生成初步解答,然后将逻辑转化为可执行代码进行验证。在这一过程中,START 模型展示了自我蒸馏与工具调用的协同作业,最终准确得出问题答案,同时利用 Python 脚本进行结果验证(p = 17 与 m = 110 的问题)。

这正是 START 模型的核心优势——利用外部执行环境来实现「验证-修正-反馈」的闭环推理,令复杂问题迎刃而解。

案例 3 —— LiveCodeBench 编程挑战

LiveCodeBench 是一项广受关注的编程基准,评估大模型在程序生成、测试用例自检等方面的能力。传统长链思维往往因复杂性导致答案缺乏鲁棒性。而借助 Hint-infer,START 模型在生成初步代码后迅速调用代码解释器,对测试用例进行运行反馈,并根据执行结果进行自动调试。最终,其 Pass@1 指标提升了近 6%——这恰恰验证了工具调用对于提升编码精度的显著作用。

🔎 分析与扩展:探索思维边界的新可能

START 模型的革新不仅在于独特的工具调用机制,更在于其自我教化的训练框架。传统大模型依赖于大数据、大参数优势,但单纯的「语言预测」终究会面临能力瓶颈。START 的两大核心技术——Hint-infer 与 Hint-RFT,赋予了模型自我反思与自我改进的能力,正如人类在不断学习中会通过实践与修正不断臻于完美。

借助 Hint-infer:

- 模型在推理链条末端被柔性激活额外的「思维进程」,能有效降低因内在计算失误导致的幻觉风险;

- 随着提示轮次的增加,模型能利用额外的「思考时间」准确校验输出,实现顺序测试时间的「正向缩放」效应(见图5)。

而 Hint-RFT 框架则将上述机制进一步升华:

- 通过拒绝采样和自我修正,模型不仅学会了如何「调用工具」,还掌握了如何在不断自省中获得最佳解;

- 在多轮微调中,种子数据($D_seed$)和扩展数据集($D_START$)使得模型能够面对更多具有挑战性的推理任务,实现从理论到实践的飞跃。

这种内外结合的思维方式,不仅为大模型推理提供了新的范式,也启发研究者尝试将其他外部工具——搜索引擎、专用库等——引入智能系统。正如自然界中复杂生态系统需互助共存,未来的人工智能也必将以跨工具协同为基础,推动更高层次的智能演化。

🛑 局限与展望:未来的路在何方?

尽管 START 模型在多个实验任务上均展现出显著优势,但任何技术的突破总伴随着局限性。首先本研究仅聚焦于 Python 解释器这一单一外部工具,未来应考虑如何引入更多样化、专业化的工具以拓宽模型应用范围。其次,提示插入虽然巧妙,但其有效性可能因任务类型或提示设计不尽相同而有所波动;进一步研究更为精细、自适应的提示策略将是亟待解决的课题。最后,由于实验基准和数据集较为有限,如何在更广泛领域下验证 START 模型的泛化性,仍需更多实证探索。

展望未来,智能模型的革命正从内部单打独斗走向内外协同共进。START 模型的自我教化与工具调用机制,无疑为下一代大模型的发展奠定了坚实基石。我们期待有更多研究者能够在这一领域不断创新,探寻智能系统的更多可能性,也为现实生活中的复杂问题求解带来革命性的新思路。

📚 附:部分关键图表与参考数据

Figure 1. START 的训练框架图

下面以 Markdown 制作示意图表,来描述整个训练框架流程:

| 阶段 | 内容描述 |

|---|---|

| Hint-infer | 在推理过程中插入预设提示,实现基础工具调用(如 Python 执行) |

| Hint-RFT | 对 Hint-infer 的输出进行评分、过滤与修改,生成高质量训练数据集 |

| RFT | 利用自蒸馏方法扩充多样性与工具调用样式,微调生成最终模型 START |

Figure 2. QwQ 与 START 的案例对比

论文中展示了一个 LiveCodeBench 「hard」 难度问题的对比图,如下:

| 模型 | 代码生成过程 | 结果 |

|---|---|---|

| QwQ | 长链思维自动生成代码,存在幻觉 | 得到错误答案 |

| START | 调用 Python 解释器自检、调试 | 反复验证后给出正确解答 |

Figure 3. Hint-Library 部分代表提示

- 「Wait,可以利用 Python 检查代码正确性」

- 「『python,等待,我将进一步验证逻辑」

- 「利用代码模板对测试用例反复调试」

Figure 5. 测试时间缩放效应

图示表明,随着提示数量(和思考时间)的增加,模型正确率呈上升趋势,验证了提示插入的有效性。

🔮 结语

START 不仅仅是一项工具整合技术,更是一种全新的智能思考模式。借助 Hint-infer 的即时启发和 Hint-RFT 的自我教化,START 模型打破了传统长链思维的局限,实现了内外协同的推理新范式。正如星辰在夜空中彼此呼应,我们也期待未来更多智能模型能在外部工具的辅助下,以更真实、更精确的方式「思考」与突破。

这一前沿探索为数字时代迈向更高认知水平铺平了道路,同时也揭示了人工智能自适应与自我修正的无限潜力。我们坚信,在不断的探索与创新中,未来的智能系统不仅能够解决更复杂的问题,更会在人机协同的宏大蓝图下,温柔地书写一段段未来科技的诗篇。

📚 参考文献

- Wei, J. et al. (2022). ✅Chain-of-Thought Prompting Elicits Reasoning in Large Language Models.

- OpenAI. (2024). Technical Report on Long Chain-of-Thought Models.

- Gou, J. et al. (2024). ✅Tool-Integrated Reasoning in Large Models.

- Li, C. et al. (2025). ✅Self-Taught Reasoner with Tools: The START Approach.

本文详细聚焦于 START 模型论文的核心创新原理、训练框架、实验对比以及未来展望,力图以浅显通俗而不失深度的叙述,带您一窥新时代大模型自我教化与工具整合背后的技术秘辛。