🌟 引言:从简单到复杂的推理革命

近年来,大型语言模型(LLMs)的后训练阶段取得了令人瞩目的进展。无论是 OpenAI 的 GPT 系列,还是其他如 DeepSeek-R1 和 Kimi-K1.5,这些模型都展示了非凡的推理能力。然而,尽管这些模型在复杂任务中的表现令人印象深刻,但其背后的推理机制仍然是一个未解之谜。更重要的是,这些能力如何被复制到更小规模的模型上,或如何在更严格的实验条件下重现,仍然是一个悬而未决的科学问题。

为了回答这些问题,《Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning》提出了一种创新性的规则强化学习框架(Logic-RL),旨在通过逻辑推理训练模型,解锁更深层次的推理能力。本文的核心目标是探索如何通过规则奖励和强化学习(RL)让模型学会复杂的逻辑推理,并在数学推理等跨领域任务中实现卓越的泛化能力。

🧠 数据的魔法:骑士与骗子的逻辑世界

🏝️ 骑士与骗子:逻辑谜题的完美试验场

在 Logic-RL 的研究中,研究者选择了一个极具趣味性和科学价值的逻辑谜题数据集——骑士与骗子(Knights and Knaves)。这个数据集的核心设定是:在一个特殊的岛屿上,所有居民要么是骑士(永远说真话),要么是骗子(永远说假话)。通过分析居民的陈述,模型需要推断出每个人的身份。

为什么选择这个数据集?原因有三:

- 程序生成,难度可控:研究者通过逻辑模板程序化生成谜题,确保数据的一致性和无限变体。这种方法允许研究者精确调整谜题的难度,例如通过增加角色数量(2-8 人)或逻辑操作的复杂性(1-4 个布尔运算组合)。

- 验证简单,答案唯一:每个谜题都有唯一的正确答案,并且可以通过算法验证。这种设计避免了自然语言任务中常见的歧义问题,使得模型的推理能力可以被清晰地评估。

- 泛化测试的理想工具:通过训练模型解决简单的谜题,再测试其在更复杂谜题上的表现,研究者能够深入研究模型的泛化能力。

🤔 一个谜题的例子

问题:

一个岛上有两位居民,Zoey 和 Oliver。Zoey 说:「Oliver 不是骑士。」 Oliver 说:「如果 Zoey 是骗子,那么我就是骑士。」那么,谁是骑士,谁是骗子?

答案:

Zoey 是骗子,Oliver 是骑士。

通过这样一个简单但逻辑严密的谜题,研究者能够观察模型是否真正理解了逻辑推理,而不是简单地记忆答案。

🎯 规则奖励:让模型学会「思考」

强化学习的核心在于奖励设计。在 Logic-RL 中,研究者设计了一套严格的规则奖励系统,确保模型不仅能得出正确答案,还能遵循逻辑推理的过程。

🏗️ 格式奖励:规范推理的框架

为了让模型输出结构化的推理过程,研究者要求模型在回答时必须使用特定的格式:

- 标签:包含模型的推理过程。

- 标签:包含最终答案。

例如,对于上述谜题,模型的回答应该是:<think> Zoey 是骗子,因为她的陈述与 Oliver 的陈述矛盾…… </think><answer> Zoey 是骗子,Oliver 是骑士 </answer>

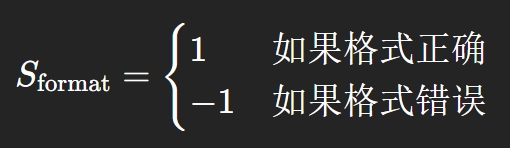

如果模型未能遵循格式要求,例如直接跳过推理过程或在错误的标签中输出答案,则会被扣分。格式奖励的计算公式为:

✅ 答案奖励:正确性至上

在格式验证通过后,研究者会检查模型的答案是否正确。答案奖励的评分机制如下:

- 完全正确:得分为 2。

- 部分错误:得分为 -1.5。

- 完全错误或答案缺失:得分为 -2。

这种双重奖励机制确保模型不仅输出正确答案,还能清晰地展示其推理过程,避免「猜答案」或「跳步推理」的行为。

🚀 强化学习算法:从 REINFORCE 到 REINFORCE++

在训练过程中,研究者采用了改进版的 REINFORCE 算法(称为 REINFORCE++)。相比传统的 PPO 或 GRPO,REINFORCE++ 在稳定性、训练效率和性能提升方面表现更优。

🔧 关键改进:KL 损失与估计

为了避免模型在训练中偏离初始策略,研究者引入了 KL 散度作为奖励函数的一部分。具体公式为:

其中,$\mathbf{I}(s_t = [\text{EOS}])$ 是一个指示函数,当模型生成结束标记时取值为 1。$\beta$ 是 KL 惩罚的权重。

此外,研究者还采用了一种无偏的 KL 估计方法,进一步提高了训练的稳定性。

🔬 实验与发现:推理能力的涌现

研究者通过一系列实验验证了 Logic-RL 的有效性,以下是一些关键发现:

📈 推理能力的提升与泛化

在仅使用 5000 个骑士与骗子谜题进行训练后,模型在 AIME 和 AMC 等高难度数学基准测试上的表现分别提升了 125% 和 38%。这一结果表明,通过 RL 训练获得的推理能力具有跨领域的泛化性,而不仅仅局限于逻辑谜题。

🤔 复杂行为的自然涌现

在训练过程中,模型逐渐展现出一些复杂的推理行为,例如:

- 自我验证:模型会在输出答案前重新检查自己的推理过程。

- 多路径探索与回溯:模型会尝试多种解题路径,并在发现矛盾时回溯到之前的步骤。

- 公式应用:模型能够自发地使用逻辑公式(如「如果 P 则 Q」)来解决问题。

这些行为并未明确出现在训练数据中,而是通过 RL 训练自然涌现的。

🌐 语言混合现象

尽管训练数据完全是英文,模型在推理过程中偶尔会插入中文词汇。这种现象可能表明,某些中文词汇的向量表示在 RL 奖励机制下具有「优势」,值得进一步研究。

🔮 未来展望:从逻辑到现实

尽管 Logic-RL 在逻辑推理任务中表现出色,但其在更大规模的数据集(如真实世界的数学或编程任务)上的泛化能力仍需进一步验证。未来的研究方向包括:

- 扩展数据规模与多样性:探索更复杂的逻辑问题和真实世界任务。

- 优化长链推理:开发将长链推理压缩为短链的高效方法,提高模型的计算效率。

- 探索语言混合的潜力:研究语言切换是否能系统性地增强推理能力。

- 放宽格式约束:允许模型自行发明内在的推理表示,可能会带来更高的灵活性和创新性。

📚 参考文献

- Tianzhe Chu et al., SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-Training, 2025.

- DeepSeek-AI et al., DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning, 2025.

- Jason Wei et al., Chain-of-Thought Prompting Elicits Reasoning in Large Language Models, 2022.

- Jian Hu, REINFORCE++: A Simple and Efficient Approach for Aligning Large Language Models, 2025.

- Fengli Xu et al., Towards Large Reasoning Models: A Survey of Reinforced Reasoning with Large Language Models, 2025.