LLM推理:原理、架构与设计思想

Denny Zhou, Google DeepMind

lightbulb

LLM推理的核心原理

LLM推理的本质是在得出最终答案之前生成一系列中间token。这种方法的关键在于,Transformer模型通过生成大量中间token,可以变得极其强大,而无需扩展模型的大小。

中间token的重要性:Denny Zhou与斯坦福大学的研究团队合作提出理论:任何可以通过布尔电路解决的问题,都可以通过生成中间token用恒定大小的transformer模型解决。这为理解LLM推理提供了理论基础。

预训练模型即使未经任何微调,也具备推理能力。挑战在于,基于推理的输出往往不会出现在输出分布的顶部,因此标准贪婪解码无法将它们呈现出来。

psychology

LLM推理的技术方法

-

alt_route

链式推理解码: 超越贪婪解码,检查更多生成候选,选择最终答案置信度更高的候选。包含两个步骤:检查更多生成候选,选择最终答案置信度更高的候选。

-

format_list_numbered

链式思维提示: 通过自然语言提示指导模型进行链式推理,如」让我们一步步思考」。这种方法使推理过程自然地出现在输出空间中,而不需要复杂的计算步骤。

-

tune

监督微调(SFT): 收集问题及人工标注的解决方法,最大化人类解决方案的可能性。虽然通用,但泛化能力有限。

-

autorenew

自我提升方法: 让模型生成数据,通过Reject Sampling选择正确的步骤。这种方法可以减少昂贵的人工标注成本,实现模型的自我改进。

-

rocket_launch

强化学习微调(RL finetuning): 当前最强大的方法,通过生成多个响应并聚合结果,极大提高LLM推理能力。在RL微调中,可靠的验证器是最关键的,而非RL算法。

architecture

LLM推理的架构设计

-

split_screen

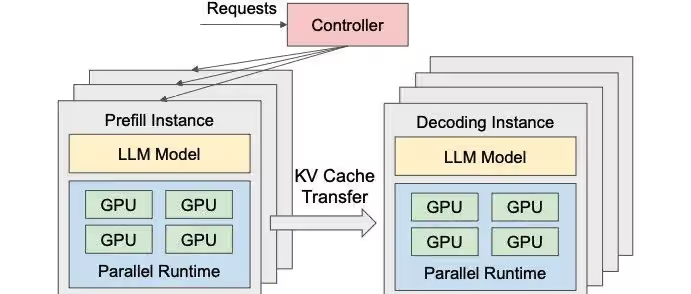

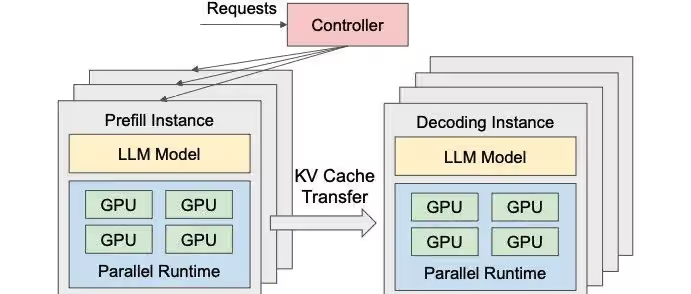

Prefill-Decode分离式架构: 将Prefill和Decode阶段拆分到不同GPU实例上独立运行。Prefill Instance专注于Prefill阶段的计算,Decode Instance专注于Decode阶段的生成任务。当Prefill Instance完成KV Cache的计算后,会将其传输给Decode Instance,后者接续生成结果。这种架构独立优化了两个阶段的性能,解决了资源争抢问题。

-

verified

GenRM技术: Google DeepMind提出的生成式验证器,使用下一个token预测目标来训练验证器,同时进行验证和解决方案生成。相比传统验证器,GenRM具有无缝集成指令调整、支持思维链推理、通过多数投票利用额外推理时间计算等优势,在算法和小学数学推理任务中性能提升16-64%。

trending_up

LLM推理的未来发展方向

直接优化我们想要的东西是机器学习中的第一性原理。随着COT(Chain of Thought)的增长,模型可以解决更多问题,而不需要增加模型尺寸。

关键洞察:LLM推理的美妙之处在于,它类似于人类的推理过程,源自逐个token的预测,而非像传统AI那样依赖搜索排序。实际性能比争论是否属于推理更重要。

通过随机抽样生成多个响应,然后选择出现频率最高的答案(边缘化),可以带来巨大的改进。此外,使用多个不同模型并行运行,对比答案,挑选最一致的结果,也是一种有效的策略。

LLM推理的核心原理

Denny Zhou, Google DeepMind

psychology

LLM推理的本质

LLM中的推理仅仅意味着在得出最终答案之前生成一系列中间token。这是否与人类推理相似并不重要,关键在于Transformer模型通过生成大量中间token可以变得极其强大,而无需扩展模型大小。

lightbulb

核心洞察

语言模型已经具备推理能力,关键在于解码过程。传统的贪婪解码方法可能无法捕捉到基于推理的输出,因为它只选择最可能的候选答案。

中间token的重要性

Denny Zhou与斯坦福大学研究团队合作提出的理论:任何可以通过布尔电路解决的问题,都可以通过生成中间token用恒定大小的transformer模型解决。

输入问题

生成中间token

输出答案

逻辑电路的大小(即电路中逻辑门的数量)决定了解决问题的能力。通过生成中间token,模型能以恒定大小的transformer架构有效地解决问题,而不需要极深的模型结构。

auto_awesome

预训练模型的推理能力

预训练模型即使未经任何微调,也具备推理能力。挑战在于,基于推理的输出往往不会出现在输出分布的顶部,因此标准贪婪解码无法将它们呈现出来。

priority_high

关键挑战

需要超越贪婪解码,检查更多的生成候选,并选择那些最终答案置信度更高的候选。这就是链式推理解码的核心思想。

LLM推理的技术方法

Denny Zhou, Google DeepMind

链式推理解码

超越传统贪婪解码,通过检查更多候选答案并选择最优解来提高推理准确率。

1

检查更多生成候选

2

选择高置信度答案

链式思维提示

通过简单的自然语言提示,直接指导模型进行链式推理,使推理过程自然地出现在输出空间中。

chat

「让我们一步步思考」

psychology

通用方法

监督微调 (SFT)

从人工标注者那里收集一系列问题及其逐步解决的方案,然后最大化人类解决方案的可能性。

person

依赖人工标注

warning

泛化能力有限

自我提升方法

让模型生成数据,通过Reject Sampling选择正确的步骤,实现模型的自我改进。

auto_awesome

减少人工标注成本

refresh

循环改进

强化学习微调 (RL finetuning)

最强大

当前最强大的方法,通过生成多个响应并将它们聚合起来,而不是依赖于单个响应,可以极大地提高LLM推理能力。

verified

可靠验证器是关键

trending_up

泛化能力优秀

groups

多实验室独立发现

LLM推理的架构设计

Denny Zhou, Google DeepMind

Prefill-Decode分离式架构

在传统LLM推理框架中,Prefill和Decode阶段通常由同一块GPU执行,而在Prefill-Decode分离式架构中,这两个阶段被拆分到不同的GPU实例上独立运行,解决了资源争抢问题。

Prefill-Decode分离式工作流程

Prefill Instance

专注于Prefill阶段的计算

KV Cache传输

完成计算后传输给Decode Instance

Decode Instance

专注于Decode阶段的生成任务

speed

性能优化

针对不同阶段的特性独立优化资源分配

timer

降低延迟

在降低首token延迟的同时提高整体吞吐量

memory

资源利用

解决Prefill(计算密集型)和Decode(存储密集型)的资源争抢

GenRM技术

Google DeepMind提出的生成式验证器,使用下一个token预测目标来训练验证器,同时进行验证和解决方案生成,克服了传统验证器无法利用预训练LLMs文本生成能力的局限性。

integration_instructions

无缝集成指令调整

与现有指令调整流程无缝集成

psychology

支持思维链推理

能够处理和验证复杂的推理过程

how_to_vote

多数投票机制

利用额外的推理时间计算提高准确性

16-64%

Best-of-N解决问题

性能提升

性能提升

算法

在算法推理任务中

表现优异

表现优异

数学

在小学数学推理任务中

性能卓越

性能卓越

LLM推理的未来发展方向

Denny Zhou, Google DeepMind

机器学习的第一性原理

直接优化我们想要的东西是机器学习中的第一性原理。如果我们想构建一个用于推理的模型,就需要优化衡量生成质量的指标。一旦有了度量标准,我们需要做的就是计算该度量标准的梯度并进行反向传播。

lightbulb

核心方法

定义指标 → 计算梯度 → 反向传播。通过采样来计算期望值,这就是策略梯度的来源。没有魔法,只使用标准的机器学习术语。

扩展方向

随着COT(Chain of Thought)的增长,模型可以解决更多问题,而不需要增加模型尺寸,只需要最小的固定大小的迁移模型。这种思路为LLM推理能力的提升提供了新的方向。

传统扩展

增加模型尺寸和参数量,计算成本高,资源消耗大

COT扩展

增加思维链长度,保持模型尺寸不变,计算效率高

LLM推理的美妙之处

LLM推理类似于人类的推理过程,源自逐个token的预测,而非像传统AI那样依赖搜索排序。这种特性使得LLM能够展现出接近人类的思维方式和推理能力。

「

Scaling的发现只会让我们更难看清发现过程是如何完成的。真正可扩展的只有两个过程,一个是学习,另一个是搜索。在这里我只想强调一件事。学习是可扩展的,我们只需要学习。

边缘化方法

通过随机抽样生成多个响应,然后选择出现频率最高的答案,可以带来巨大的改进。这种方法在实证中被称为边缘化,通过采样来计算潜在变量的和。

insights

实现方式

随机抽样生成多个响应 → 选择出现频率最高的答案 → 不看推理通过率,只选择最常见的答案。这种简单而有效的方法可以显著提高LLM的推理能力。

实际性能优先

关于检索和推理的争论并不重要,实际性能比争论是否属于推理更重要。如果检索能够获得A级答案,那就是有效的方法。使用多个不同模型并行运行,对比答案,挑选最一致的结果,也是一种有效的策略。

priority_high

关键洞察

在工业界应用中,实际性能比理论争论更重要。无论是检索还是推理,只要能够提供高质量的答案,就是有价值的方法。