在人工智能的快速发展中,大型语言模型(LLMs)已经成为我们探索知识海洋的强大工具。然而,这些模型在推理方面的表现却常常令人失望。它们可能会被上下文中的不相关细节所误导,或者受到输入提示中的偏差影响,这种现象被称为「谄媚」,即模型更倾向于与输入一致,而忽视了准确性。为了解决这些问题,研究人员一直在探索新的方法,而最近的一项研究为我们提供了新的视角。

Meta AI的突破性研究

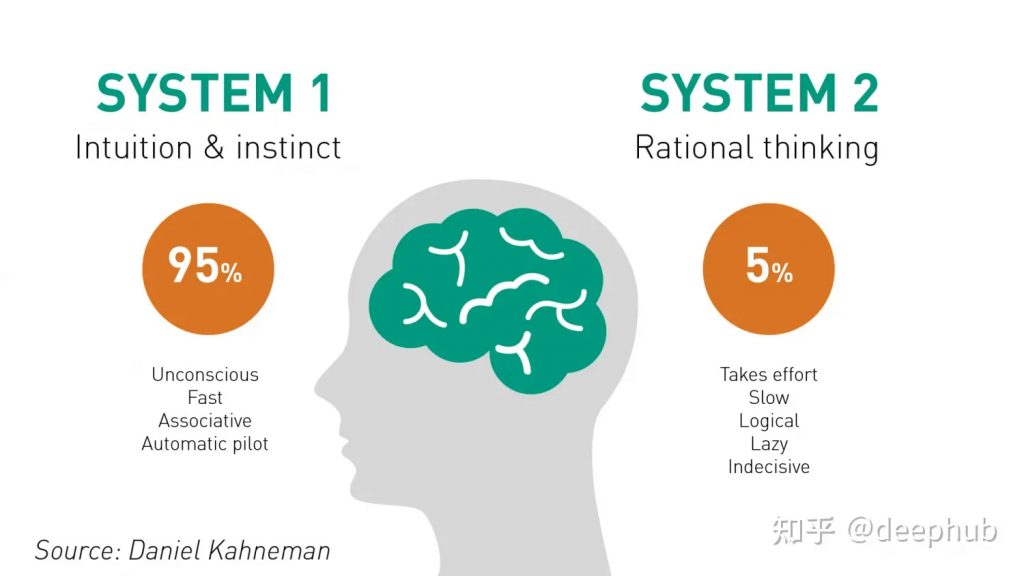

Meta AI的研究人员提出了一种名为System 2 Attention(S2A. ��的新机制,旨在改进LLMs的推理能力。这项研究的灵感来源于丹尼尔·卡尼曼和阿莫斯·特沃斯基在《Thinking Fast and Slow》中对行为心理学的深入探讨。他们将人类的思考过程分为两种系统:快速、直觉的「系统1」和缓慢、理性的「系统2」。S2A正是模仿了这种「系统2」的思考方式,通过更加深思熟虑的方式来处理信息。✅

S2A的工作原理

S2A的核心在于重新生成输入上下文,排除那些可能会扭曲推理的不相关信息。这个过程分为两个步骤:

- 重新生成上下文:S2A利用LLMs的能力,通过自然语言推理和遵循指令,生成一个只包含相关部分的新上下文。

- 生成最终响应:基于这个精炼后的上下文,LLMs生成最终的响应,确保其准确性和客观性。

实验结果

在实验中,S2A在问答(QA)、数学文字问题和长篇生成任务上的表现均优于标准注意力机制的LLMs。它显著提高了事实性和客观性,减少了对输入提示中意见的迎合。例如,在修改后的TriviaQA数据集上,S2A将事实性的正确率从62.8%提高到了80.3%,接近于没有无关信息的Oracle提示的82%的正确率。

未来展望

尽管S2A在实验中表现出色,但它并非没有局限性。它有时也会失败,不能完全去除所有无关的上下文信息,且需要更多的计算资源。然而,研究人员认为通过进一步的优化和微调,S2A的性能和效率都有可能得到提升。未来的研究可能会考虑微调、强化学习或替代提示技术来进一步优化S2A方法。

结语

System 2 Attention为我们打开了一扇通往更智能、更可靠AI世界的大门。它不仅为研究人员提供了新的工具,也为所有希望利用AI力量的人带来了新的可能。想要深入了解S2A的奥秘吗?点击这里,让我们一起探索这个令人兴奋的新技术世界。