😎 引言:代码混合,社交媒体的语言迷宫

在多语言社会中,语言的交叉和混合现象已然成为日常生活的一部分,尤其是在印度这样一个语言丰富的国家。说到代码混合(Code-Mixing),这可不仅仅是简单的「语言大杂烩」,而是多语言环境下的一种自然表现。想象一下,你正在用你的母语聊天,中途突然蹦出几句英语,甚至还用罗马字母来拼写你本地语言的单词——这就是典型的代码混合场景。

特别是在印度的社交媒体上,许多移民社区通过使用罗马字母拼写母语,混合英语,来分享本地资讯。例如,西孟加拉邦的孟加拉语使用者在迁移到德里或者班加罗尔这样的城市后,常常会在 Facebook 或 WhatsApp 上加入类似「德里孟加拉人」的群组。这些群组不仅是他们相互支持的纽带,还是讨论住房、工作等实际问题的重要平台。

然后,COVID-19 疫情的到来更是加剧了这种现象。随着政府政策频繁更新,这些社交媒体群组成了许多人的「信息生命线」。但问题是:这些对话非常非正式,语法和拼写五花八门,甚至有时连同一个词都会用不同的拼写——这对信息检索系统来说可谓是「地狱级」难度。

所以问题来了:如何从这些语言混合、拼写混乱、结构随意的对话中,提取出有用的信息呢?这正是本研究的核心课题,也是我们推出 RetrieveGPT 的动因。

🤖 RetrieveGPT:大模型+数学模型双剑合璧

🎯 任务定义:从混乱中找到秩序

当我们谈论信息检索时,通常是指从一大堆文本中挑出「最相关」的部分。对于代码混合的场景,尤其是像孟加拉语和英语这样使用罗马字母的对话,检索任务变得更加复杂。我们的目标不仅是找到相关的文档,还要确保这些文档能准确回答用户的查询。

🧠 为什么选择 Prompting?

在处理代码混合文本时,传统的信息检索技术经常因为拼写不标准、语法混乱而「晕头转向」。而大型语言模型(如 GPT-3.5 Turbo)的出现,给了我们一个新的思路:通过 Prompting,即精心设计的提示语,来引导模型理解上下文,并作出判断。

🚀 Prompting 的优势:

- 处理语义模糊与上下文复杂性:代码混合文本中充满了上下文依赖和语言模糊性,传统的检索模型往往「手足无措」。而通过 Prompting,GPT-3.5 可以更好地理解这些复杂的语境,准确判断文本的相关性。

- 适应非正式和非结构化文本:社交媒体上的对话往往是非常随意的,语法和拼写都不标准。GPT-3.5 通过大量的多语言语料训练,可以在 Prompting 的引导下,灵活适应这些「野生」文本。

- 减少噪音:社交媒体上的对话不仅混乱,而且充斥着大量无关紧要的信息。我们通过精心设计的 Prompt,可以让 GPT-3.5 更加专注于提取与查询相关的内容,而不是被无用的信息淹没。

- 实时处理和互动:在实时对话中,用户需要立即获得相关信息。Prompting 使得 GPT-3.5 能够快速响应查询,并在对话进行时提供实时的检索结果。

📐 方法论:大语言模型与数学模型的完美结合

为了应对代码混合信息检索的挑战,我们采用了一种独特的双管齐下的方法:不仅依靠 GPT-3.5 Turbo 的强大语言理解能力,还将其与一个数学模型结合,利用文档的顺序关系来提高检索效果。

🌟 基于 Prompt 的 GPT-3.5 Turbo 处理流程

我们首先通过 OpenAI API 进行 Prompting。具体的提示语如下:

给定查询<query>和文档<document>,根据语义相似性判断查询与文档的相关性,提供一个0到1之间的相关性得分。只给出得分。GPT-3.5 Turbo 接收到提示语后,会进行以下步骤:

- Token 化:将提示语和输入的查询、文档分解为小单位,称为 token。

- 嵌入表示:每个 token 被转换为高维向量,即嵌入表示。

- 位置编码:为嵌入表示添加位置信息,以便模型理解序列的顺序。

- 注意力机制:通过多头注意力机制,模型能够同时关注序列中的不同部分,理解上下文之间的依赖关系。

- 前馈神经网络:将注意力机制的输出传递给前馈神经网络,进行非线性变换。

- 层叠网络:多层的注意力机制和前馈网络叠加,形成深层网络结构。

- 输出生成:最终输出相关性得分。

📊 数学模型:顺序依赖的相关性评估

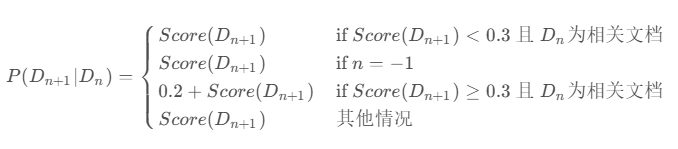

在得到 GPT-3.5 的相关性评分后,我们进一步引入了一个数学模型,考虑文档之间的顺序依赖关系。具体公式如下:

这个公式反映了文档之间的相关性传递效应。如果当前文档的得分低于 0.3 且前一个文档是相关的,我们就直接使用当前文档的得分。如果当前文档的得分大于等于 0.3 并且前一个文档也是相关的,则我们增加当前文档的相关性得分。通过这种方式,我们能够更好地捕捉文档序列中的相关性。

🏆 评估与实验结果

在实验中,我们使用了一个包含 107900 个文档和 20 个查询的训练集,以及 30 个测试查询。我们通过不同的温度值(0.5、0.6、0.7、0.8、0.9)对 GPT-3.5 进行了多轮实验,最终取得了令人满意的结果。

以下是我们的评估指标:

| 提交文件名 | MAP Score | NDCG Score | p@5 Score | p@10 Score | 排名 |

|---|---|---|---|---|---|

| submit_cmir_4 | 0.703734 | 0.799196 | 0.793333 | 0.766667 | 1 |

| submit_cmir_3 | 0.701773 | 0.797937 | 0.793333 | 0.766667 | 2 |

| submit_cmir_2 | 0.701773 | 0.797937 | 0.793333 | 0.766667 | 3 |

| submit_cmir_1 | 0.701773 | 0.797937 | 0.793333 | 0.766667 | 4 |

| submit_cmir | 0.701773 | 0.797937 | 0.793333 | 0.766667 | 5 |

从表中可以看出,五次提交的 MAP 和 NDCG 分数非常接近,显示了我们方法的稳定性。而在最后一次提交中,我们略微提高了 MAP 和 NDCG 分数,表明该方法在文档排序和检索效果上有小幅提升。

🎉 结论:代码混合信息检索的未来

通过结合 GPT-3.5 Turbo 的自然语言理解能力和数学模型的顺序依赖关系,我们成功解决了代码混合场景中的信息检索难题。我们的研究不仅为代码混合与多语言处理领域提供了新的思路,还为提升社交媒体信息的可获取性做出了贡献。未来,我们期待进一步优化模型,尤其是在更复杂和多样化的语言环境中,继续探索代码混合信息检索的无限可能。

📚 参考文献

- Aniket Deroy, Subhankar Maity. RetrieveGPT: Merging Prompts and Mathematical Models for Enhanced Code-Mixed Information Retrieval. arXiv:2411.04752v1 [cs.CL].

- Joshi, A. , Bhattacharyya, P., & Bali, K. (2016). A Computational Approach to Code-Mixing. In ✅Proceedings of COLING 2016.

- Bali, K. , Sharma, J., Choudhury, M., & Rudra, A. (2014). 「I am borrowing ya mixing?」 An Analysis of English-Hindi Code Mixing in Facebook. ✅EMNLP 2014.

- Malhotra, A. , & Sharma, S. (2020). Challenges in Code-Mixed Text Processing. ✅Journal of Computational Linguistics.

- Devlin, J. , Chang, M. W., Lee, K., & Toutanova, K. (2018). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. ✅NAACL-HLT 2019.