在生成模型的世界里,扩散模型(Diffusion Models)已经成为不容忽视的明星。它们能够生成令人惊叹的图像、视频甚至三维物体。然而,这些模型的一个致命弱点是生成速度:每次生成都需要多次迭代调用神经网络,像是一个精致的钟表匠在每一步都小心翼翼地调整齿轮。这种缓慢的生成过程严重限制了扩散模型在实际应用中的潜力,尤其是在需要快速响应的交互式场景中。

但今天,我们要讲述一个关于速度与效率的故事:f-散度分布匹配框架(f-distill)。这项由 NVIDIA 的研究团队提出的新方法,能够将多步扩散模型的生成过程浓缩为一步,同时保持甚至提升生成质量。更重要的是,它不仅是对现有方法的改进,更是对生成模型训练理论的一次重要扩展。

🌀 扩散模型的困境:慢如蜗牛的生成过程

扩散模型的工作原理可以类比为「从噪声中寻找秩序」。它们通过一个正向过程将干净的数据逐渐加噪,直到变成纯噪声;然后通过一个反向过程,从噪声中逐步恢复出数据。这种反向过程通常被描述为求解一个微分方程(ODE)或随机微分方程(SDE)。

然而,这个反向过程的一个显著问题是:它需要多次迭代。即使是优化过的扩散模型,也需要几十甚至上百步的采样迭代来生成一张高质量的图像。这种「步步为营」的策略虽然保证了生成质量,但却牺牲了速度。

早期的加速尝试主要集中在改进数值求解器上,比如更高效的 ODE/SDE 求解方法。然而,这些方法的加速效果有限,通常只能将采样步数减少到几十步,依然无法满足实时生成的需求。

于是,研究者们开始探索更激进的解决方案:能否将多步生成过程压缩到一步?

🚀 一步生成的梦想:从轨迹蒸馏到分布匹配

为了实现一步生成,研究者们提出了两大类方法:

- 轨迹蒸馏(Trajectory Distillation):

这种方法试图将扩散模型的多步采样过程「蒸馏」成一个一步的映射函数。换句话说,它试图学习一个直接从噪声到数据的映射。然而,这种方法的挑战在于,扩散模型的采样轨迹通常非常复杂,直接学习这个映射难度极高,效果也不够理想。 - 分布匹配(Distribution Matching):

与其试图学习复杂的采样轨迹,不如直接关注结果。分布匹配方法的核心思想是:让一步生成器的输出分布尽可能接近多步扩散模型的输出分布。通过这种方式,生成器不需要精确还原采样轨迹,只需保证最终生成的样本分布一致即可。

分布匹配方法在实践中表现出了更好的效果,但它也有自己的问题:如何选择合适的分布匹配指标?

🔍 f-散度的引入:从 KL 到更广泛的视角

在现有的分布匹配方法中,最常用的指标是反向 Kullback-Leibler 散度(Reverse-KL Divergence)。这种方法通过最小化反向 KL 散度,让学生模型的分布尽可能贴近教师模型的分布。然而,反向 KL 散度有一个显著的缺点:它偏向于「模式追踪」(Mode-Seeking)。

什么是模式追踪?简单来说,反向 KL 散度倾向于让生成器专注于数据分布中概率密度最高的区域,而忽略那些概率较低但同样重要的模式。这种偏好可能导致生成器生成的样本缺乏多样性,无法覆盖数据分布的所有模式。

为了解决这个问题,本文提出了一个更通用的框架:f-散度分布匹配(f-distill)。

什么是 f-散度?

f-散度是一类广义的分布差异度量,它的定义如下:

其中,fff 是一个凸函数,通过选择不同的 fff,我们可以得到不同的散度指标,比如:

- 反向-KL:

- 正向-KL:

- Jensen-Shannon 散度(JS):

通过引入 f-散度,研究者们能够在分布匹配中灵活选择不同的散度指标,从而在模式覆盖(Mode Coverage)和模式追踪之间找到更好的平衡。

🧠 f-distill 的核心:权重函数与梯度更新

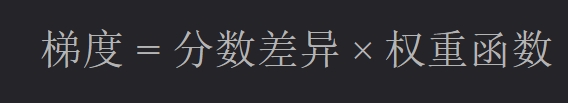

f-distill 的核心创新在于,它将 f-散度的梯度公式化为一个简单且直观的形式:

具体来说,f-distill 的梯度由两部分组成:

- 分数差异:即教师模型和学生模型的分数函数(score function)之间的差异。这部分确保学生模型能够逐步逼近教师模型的分布。

- 权重函数:由 f-散度和密度比决定,用于调整不同样本对梯度的贡献。

权重函数的引入是 f-distill 的关键突破。它能够自适应地降低低密度区域的分数差异权重,从而减少这些区域的梯度噪声。

例如,在 Jensen-Shannon 散度下,权重函数会对教师分布中低密度区域的样本赋予更低的权重。这种机制能够有效避免模型在这些区域过度拟合,从而提升训练的稳定性和生成质量。

📊 实验结果:一步生成的巅峰表现

研究者们在多个数据集上验证了 f-distill 的效果,包括 CIFAR-10、ImageNet-64 和 MS-COCO 的文本到图像生成任务。结果显示:

- 生成质量

在 ImageNet-64 上,使用 Jensen-Shannon 散度的 f-distill 达到了当前最优的一步生成性能,FID 分数仅为 1.16,远超其他方法。 - 多样性

与反向-KL 方法相比,f-distill 在生成样本的多样性上表现更优,尤其是在使用正向-KL 和 JS 散度时。 - 稳定性

实验还表明,f-distill 的权重函数能够显著降低梯度的方差,尤其是在大规模数据集(如 COYO-700M. ��上,训练过程更加稳定。✅

🌟 结语:f-distill 的未来潜力

f-distill 不仅是一种更高效的扩散模型蒸馏方法,更是对生成模型分布匹配理论的一次重要扩展。通过引入 f-散度,研究者们为生成模型的训练提供了更大的灵活性和更强的适应性。

未来,f-distill 的潜力不仅限于图像生成。它还可以扩展到视频生成、三维建模甚至自然语言生成等领域,为生成模型的高效训练开辟新的可能性。

在生成模型的高速公路上,f-distill 就像是一辆超级跑车,用一次优雅的加速,带我们驶向更快、更高效的未来。

参考文献

- Xu, Y. , Nie, W., & Vahdat, A. (2025). One-step Diffusion Models with f-Divergence Distribution Matching.✅

- Ho, J. , Jain, A., & Abbeel, P. (2020). Denoising Diffusion Probabilistic Models.✅

- Song, Y. , & Ermon, S. (2019). Generative Modeling by Estimating Gradients of the Data Distribution.✅