在 AI 世界的风云变幻中,马斯克的 Grok3 刚刚掀起一阵热潮,而 Sam Altman 还在犹豫是否要开源时,DeepSeek 的研究团队却抢先一步,发布了一项令人瞩目的研究成果——原生稀疏注意力(Native Sparse Attention, NSA)。这项技术不仅硬件友好,还能在长文本建模中实现效率与性能的双赢,堪称 LLM(大语言模型)领域的又一里程碑。

梁文锋,DeepSeek 的 CEO,同时也是这篇论文的联合作者,用实际行动向世界证明:真正的技术领导者不仅能管理企业,还能站在研究的最前沿。这篇论文的发布,不仅让 DeepSeek 成为行业焦点,更让人们惊呼:「这才是真正的 OpenAI!」

接下来,让我们一起深入探讨这篇论文的核心内容,看看 NSA 技术是如何重新定义长文本建模的。

🌌 长文本建模的挑战:从理论到现实的鸿沟

近年来,长文本建模的重要性愈发凸显。无论是深度推理、代码库生成,还是多轮对话,AI 模型都需要具备处理超长序列的能力。例如,OpenAI 的 o-series 模型、DeepSeek-R1,以及 Google 的 Gemini 1.5 Pro,都展示了在处理长文本时的巨大潜力。

然而,传统的 Attention 机制却成为了长文本建模的「拦路虎」。Attention 的计算复杂度随着序列长度的增加呈平方级增长$O(n^2)$,这意味着当序列长度达到数万甚至数十万时,计算成本和延迟会急剧上升。如何在不牺牲模型性能的前提下,提升长文本处理的效率,成为了 LLM 发展的关键问题。

🧩 稀疏注意力的出现:从瓶颈到突破

稀疏注意力的核心思想是:并非所有的 Token 都需要彼此交互。通过选择性地计算关键的 Query-Key 对,可以显著降低计算量,同时保留模型的性能。然而,现有的稀疏注意力方法在实际应用中仍面临诸多挑战,比如推理效率的「假象」和训练阶段的「盲点」。DeepSeek 的 NSA 技术正是在这一背景下应运而生,为稀疏注意力带来了全新的解决方案。

🧠 NSA 的核心创新:动态分层稀疏与硬件优化的完美结合

DeepSeek 提出的 NSA 技术,结合了算法创新与硬件优化,为长文本建模带来了前所未有的效率和性能提升。其核心亮点可以归纳为以下两点:

1️⃣ 动态分层稀疏策略:全局与局部的完美平衡

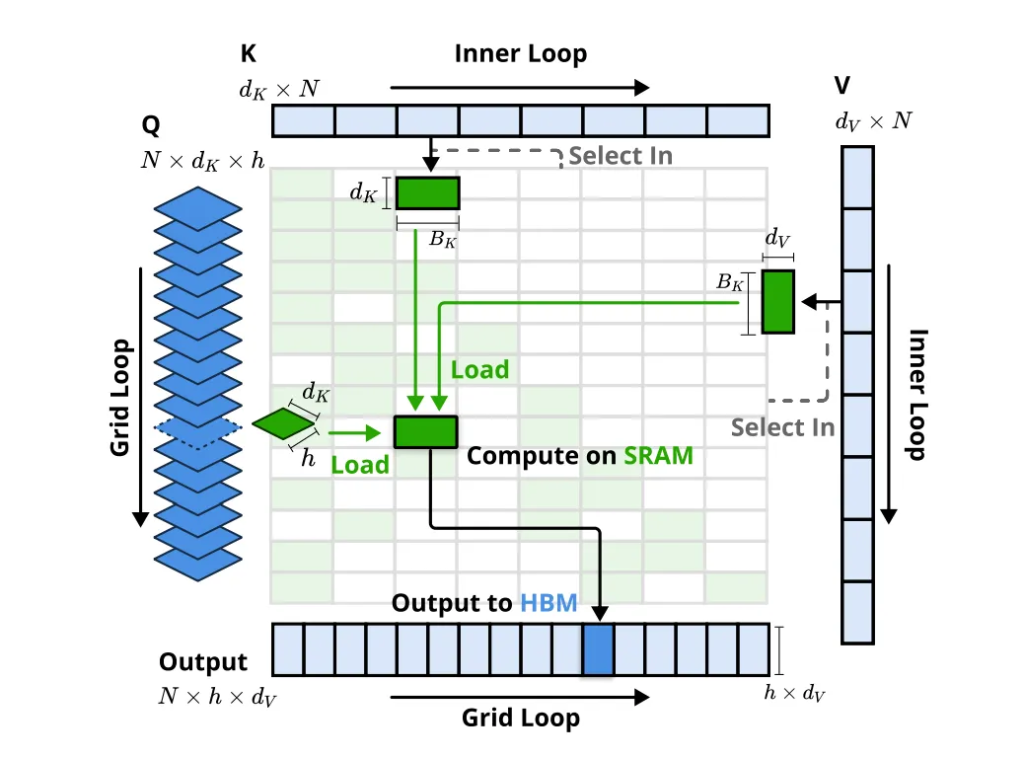

NSA 采用了一种动态分层的稀疏策略,通过结合粗粒度的 Token 压缩和细粒度的 Token 选择,实现了全局上下文感知与局部信息精确性的兼顾。

- 粗粒度的 Token 压缩:将大块的 Token 聚合为更紧凑的表示,捕获全局模式。

- 细粒度的 Token 选择:从序列中选择最重要的 Token,保留关键的局部信息。

这种分层设计不仅减少了计算量,还能有效避免信息丢失,使模型在处理长序列时既高效又精准。

2️⃣ 两大关键创新:硬件友好与训推一体化

💻 算术强度平衡的算法设计与硬件优化

NSA 的算法设计充分考虑了现代硬件的特性,通过优化算术强度(Arithmetic Intensity),实现了计算与内存访问的平衡。其专为 GPU Tensor Core 设计的内核(Kernel)能够最大化硬件利用率,显著提升计算速度。

🏋️♀️ 端到端可训练

与许多稀疏注意力方法仅在推理阶段应用不同,NSA 支持端到端训练。这意味着它不仅能在推理阶段高效运行,还能在预训练过程中减少计算量,同时保持甚至提升模型性能。

📊 实验结果:性能与效率的双重胜利

DeepSeek 的实验结果令人惊艳!在通用基准测试、长文本任务和指令推理方面,使用 NSA 预训练的模型性能不仅没有下降,反而超越了 Full Attention 模型。

🚀 速度提升:最高达 11.6 倍

在处理 64k 长度的序列时,NSA 在解码、前向传播和反向传播等各个阶段都实现了显著的速度提升,最高可达 11.6 倍!这充分证明了 NSA 在模型生命周期各个阶段的效率优势。

| 阶段 | 速度提升倍数 |

|---|---|

| 解码 | 9.0× |

| 前向传播 | 6.0× |

| 反向传播 | 11.6× |

🏆 性能提升:全面超越 Full Attention

在多个任务上的表现中,NSA 不仅保持了 Full Attention 的性能,还在许多关键任务上实现了超越。例如,在长文本任务和复杂推理任务中,NSA 的表现尤为突出。

🤔 现有稀疏注意力方法的局限性:NSA 如何解决?

论文还深入分析了现有稀疏注意力方法的局限性,并针对这些问题提出了 NSA 的解决方案。

1️⃣ 推理效率的「假象」

许多方法虽然在理论上实现了稀疏计算,但在实际推理中提升有限。这主要是因为:

- 阶段限制的稀疏性:例如,有些方法只在自回归解码时应用稀疏性,但在预填充阶段仍需要大量计算。

- 与先进 Attention 架构的不兼容性:一些方法难以适配现代高效解码架构(如 MQA 和 GQA),导致内存访问瓶颈依然存在。

2️⃣ 可训练稀疏性的「神话」

许多方法忽略了训练阶段的稀疏性,导致:

- 性能退化:后验应用稀疏性可能导致模型偏离预训练的优化轨迹。

- 训练效率低下:例如,Token 粒度的选择策略可能导致非连续的内存访问,影响硬件利用率。

🧩 NSA 的核心组件:分层稀疏,逐层优化

为了克服上述局限性,NSA 架构采用了分层 Token 建模,并通过三个并行的注意力分支处理输入序列:

- 压缩注意力(Compressed Attention):处理粗粒度的模式,通过压缩 Token 块捕获全局信息。

- 选择注意力(Selected Attention):处理重要的 Token 块,选择性地保留细粒度的信息。

- 滑动窗口注意力(Sliding Window Attention):处理局部上下文信息。

这三个分支的输出通过一个门控机制进行聚合,同时 NSA 的硬件优化内核设计确保了其高效性。

🔮 未来展望:NSA 的潜力与应用

DeepSeek 的 NSA 技术不仅为长文本建模带来了新的突破,还为稀疏注意力领域提供了全新的思路。其硬件友好设计和训推一体化特性,使其在实际应用中更具优势,有望加速下一代 LLM 在长文本处理领域的落地。

未来,我们期待看到更多基于 NSA 技术的创新应用,例如:

- 更高效的代码生成与调试工具。

- 支持超长文档分析的智能助手。

- 在科研、教育等领域的长文本推理任务。

🎉 写在最后:DeepSeek 的技术领导力

梁文锋作为 DeepSeek 的 CEO,同时也是这篇论文的联合作者,展现了技术领导者的真正风采。他不仅引领团队发布了这一重量级研究成果,还亲自参与了最前沿的研究工作。这种兼具管理能力与技术深度的领导力,无疑为 DeepSeek 的未来发展奠定了坚实基础。

网友们纷纷感叹:「这才是真正的 OpenAI!」 DeepSeek 的 NSA 技术,或许正是开启 LLM 长文本建模新时代的钥匙。

参考文献:

- Yuan, J. , Gao, H., Dai, D., et al. (2025). Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention. ✅arXiv preprint arXiv:2502.11089v1.

- Vaswani, A. , Shazeer, N., Parmar, N., et al. (2017). Attention Is All You Need. ✅Advances in Neural Information Processing Systems (NeurIPS).

- Zaheer, M. , Guruganesh, G., Dubey, K. A., et al. (2020). Big Bird: Transformers for Longer Sequences. ✅Advances in Neural Information Processing Systems (NeurIPS).

有点像miniMax 01的分块注意力

预计缺点是对 coding 非常不友好

训练时可用是非常大的突破

这就对RAG应用不友好

主要还是内存IO太多,虽然稀疏访问,但是没有考虑内存的block特性,一次连续读64字节是最高效的。

即: 粗-细-局部