在人工智能日新月异的今天,语言模型(LLMs)正如火山喷发般涌现而出,然而它们的推理能力却常常让人捉襟见肘。本文将带您深入探讨OpenAI的最新系统o1,看看它在推理优化的道路上,是否依然保留着来自自回归(autoregression)训练的「余烬」。

🧠 语言模型的自回归之路

自回归的训练方法可以说是语言模型的源头活水。正如McCoy等人(2023)所指出的,语言模型的主要目标是预测下一个词,即在给定的文本开头,模型通过概率推断出接下来最有可能出现的词。这种训练方式的直接后果是,模型对文本的概率敏感。这意味着,当模型面对常见的任务和高概率的文本时,它的表现通常会更佳。试想一下,您在参与一场拼字游戏时,面对一个熟悉的单词,您自然能够顺畅地说出它的拼写;而面对一个陌生的词汇,您可能就会犹豫不决。

在我们的研究中,我们发现,即便是在与自回归预测看似截然不同的任务中,语言模型的表现依然带有自回归的印记。例如,当要求模型反转一个单词列表时,若输出的反转序列是高概率的单词序列,模型的表现就会显著优于低概率的序列。

🔍 o1的登场

OpenAI的新系统o1,旨在优化推理能力,似乎为这一局面带来了新的希望。o1被训练用于解决推理问题,通过一系列思维步骤逐渐推导出最终答案。虽然其工作原理的具体细节尚未完全公开,但可以肯定的是,o1的训练过程中仍然涉及到自回归预测。

我们的研究表明,o1在许多评估任务中表现优越,尤其在处理常见任务的稀有变体时更是表现出色。然而,令人惊讶的是,它仍然展现出与以往模型相似的定性行为特征。具体来说,o1在高概率输出的情况下,表现明显优于低概率输出的情况。

📊 数据可视化:展示o1的表现

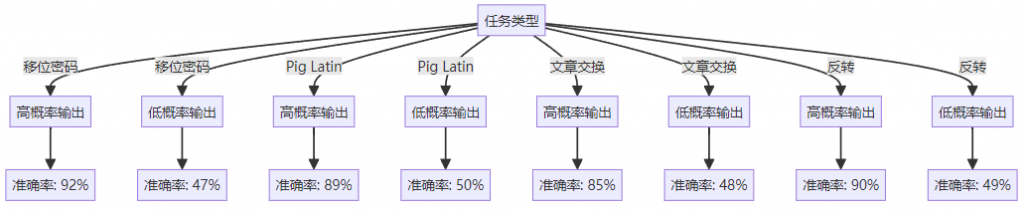

以下是我们在四个任务(移位密码、Pig Latin、文章交换和反转)中的结果。通过图表,我们可以清晰地看到o1的表现和其他语言模型的比较。

这个图表揭示了o1在不同任务下对输出概率的敏感性,显示出在高概率情况下的准确性显著高于低概率情况。

🤔 任务频率与模型表现

除了输出概率,我们还考察了任务频率对o1表现的影响。我们发现,o1在处理常见任务变体时,表现相对稳定,而在稀有任务变体上,尽管准确率相似,所使用的tokens数量却明显不同。例如,当我们增加任务的难度时,o1在处理常见变体时的表现优于稀有变体。

🧩 结合模型的优化

这引发了一个有趣的思考:o1是否在某种程度上仍然受到自回归的影响?我们认为,虽然o1优化了推理能力,但它的训练过程可能仍旧包含自回归预测的成分。这意味着,在生成文本的过程中,模型可能会倾向于选择高概率的文本输出。

🔮 未来的方向

尽管o1在许多任务中表现优越,但仍然存在挑战。如何进一步减少自回归带来的影响,提升模型的推理能力,可能是未来研究的重要方向。例如,考虑引入不涉及概率判断的模块,例如执行Python代码的模块,可能会是一个解决方案。

在这条探索的道路上,o1无疑是一个重要的里程碑,它展示了推理与自回归之间的复杂关系。尽管AI的未来充满希望,但我们也要清醒地认识到,当前的模型仍然带有自回归的「余烬」。

📚 参考文献

- McCoy, R. T., Yao, S., Friedman, D., Hardy, M. D., & Griffiths, T. L. (2023). Embers of Autoregression. arXiv:2410.01792.✅

- Elman, J. L. (1990). Finding structure in time. Cognitive Science, 14(2), 179-211.✅

- Radford, A. , Wu, J., & Child, R. (2018). Improving language understanding by generative pre-training. OpenAI.✅

- Nye, M. , et al. (2021). Learning to reason with LLMs. arXiv:2402.00001.✅

- Prabhakar, A. , et al. (2024). The effects of chain-of-thought reasoning on LLM outputs. arXiv:2402.00002.✅