引言

在生成扩散模型的应用中,如何在保证生成质量的前提下减少采样步数一直是一个关键问题。本文将介绍一种名为「Skip Tuning」的加速技巧,该技巧出自论文《The Surprising Effectiveness of Skip-Tuning in Diffusion Sampling》。通过合理的调节Skip Connection的权重,可以在保持生成质量的同时进一步压缩采样步数,实现更快速的采样过程。

模型回顾

首先,我们需要回顾一下生成扩散模型中的主流架构——U-Net。U-Net最早出自论文《U-Net: Convolutional Networks for Biomedical Image Segmentation》,其特点是输入和输出的大小一致,适合图像分割任务。U-Net在生成扩散模型中也被广泛采用,因为它能够很好地捕捉图像的细节信息。

U-Net的核心是Skip Connection,即在逐层下采样和上采样的过程中,添加了额外的连接来避免信息瓶颈。这些Skip Connection使得第一层的输出可以直接传递到倒数第一层,第二层的输出可以传递到倒数第二层,依此类推。这样可以解决信息流动受限的问题,尤其是在重构和去噪任务中,避免生成模糊的结果。

Skip Tuning 方法

Skip Tuning是一种特别简单有效的加速技巧,适用于已有的加速技术。其核心思想是通过调节Skip Connection的权重来补偿加速过程中损失的非线性能力。具体来说,在扩散模型的采样过程中,采样是一个多步递归地从初始状态到目标状态的过程,这构成了一个复杂的非线性映射。Skip Tuning通过调节Skip Connection的权重来增加模型的非线性能力,从而提高采样质量或者减少采样步数。

假设有多个Skip Connection,我们将最靠近输入层的Skip Connection的权重设为一个较大的值,最远离输入层的Skip Connection的权重设为一个较小的值,剩下的按照深度均匀变化。通常情况下,我们设最靠近输入层的权重为1,这样基本上只有最远离输入层的权重需要调节。

实验效果

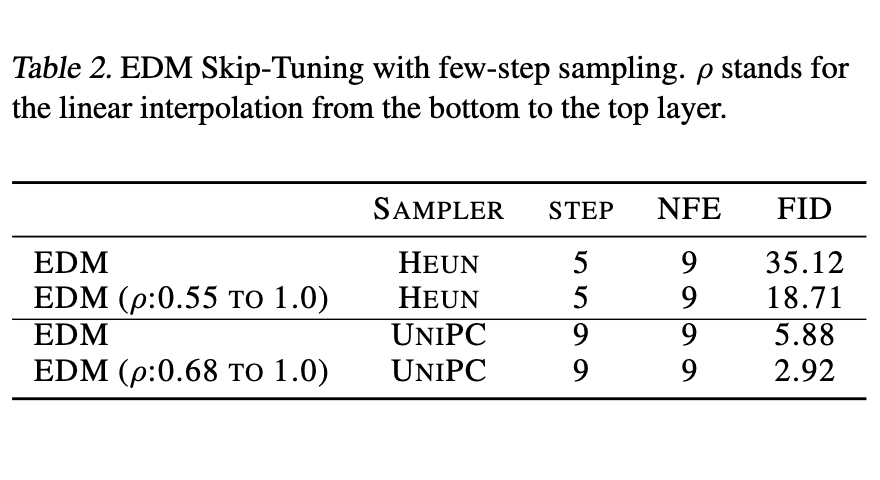

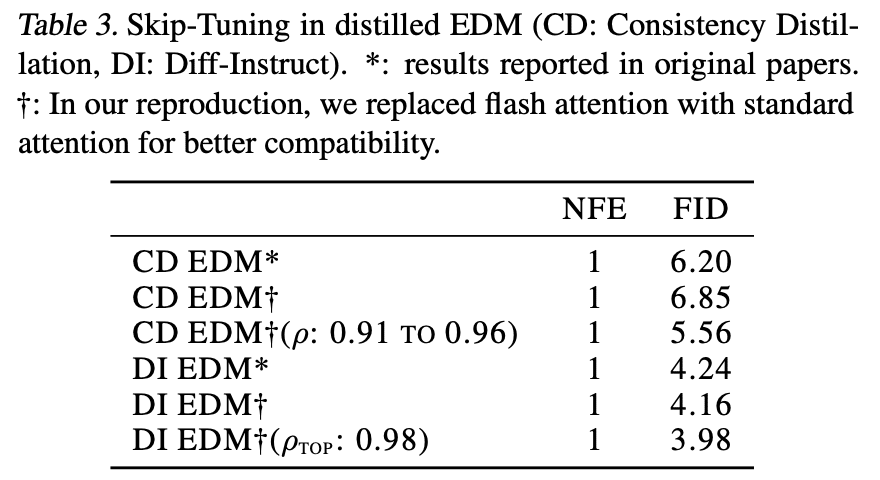

Skip Tuning的实验效果非常显著,以下是两个实验结果的表格展示:

从实验结果可以看出,通过Skip Tuning,可以在保持采样质量的情况下显著减少采样步数。

个人思考

Skip Tuning方法简单明快,却体现了作者别出心裁的想象力和观察力。这与《生成扩散模型漫谈(二十三):信噪比与大图生成(下)》中的内容相呼应,展示了不同思路在生成扩散模型中的应用。

与Skip Tuning比较相关的一篇论文是《FreeU: Free Lunch in Diffusion U-Net》,该论文分析了U-Net的不同成分在扩散模型中的作用。发现Skip Connection主要负责添加高频细节,而主干部分则主要负责去噪。Skip Tuning的实质是在降低采样步数时,通过调节Skip Connection的权重,增强主干的去噪能力。

对于没有Skip Connection的模型,如DiT,也可以通过调节残差来获得类似的效果,因为残差的设计本质上与Skip Connection类似,都是线性正则化的inductive bias。

文章总结

本文介绍了一个能有效提高扩散模型加速采样后生成质量的技巧——降低U-Net的Skip Connection的权重。整个方法框架非常简单明快,直观易懂,值得学习和应用。

转载本文请包括本文地址:https://kexue.fm/archives/10077

更详细的转载事宜请参考:《科学空间FAQ》

如果您还有什么疑惑或建议,欢迎在下方评论区继续讨论。

如果您觉得本文不错,欢迎分享或打赏本文。打赏并非为了获得收益,而是希望知道科学空间获得了多少读者的真心关注。再次表示欢迎和感谢!

苏剑林. (Apr. 23, 2024). 《生成扩散模型漫谈(二十四):少走捷径,更快到达》[Blog post]. Retrieved from 科学空间