在各种音频处理任务中,语音分离技术就像是个调皮的小孩,常常让传统的循环神经网络(RNN)感到束手无策。尽管RNN在序列学习领域一度风光无限,但其固有的顺序计算特性就像是拖着沉重的行李,难以实现真正的并行计算。随着变压器(Transformers)模型的出现,这一切开始发生改变。本文将带您深入探讨一款名为SepFormer的全新模型,它将RNN抛在了身后,迈上了语音分离的新征程。

📚 变压器的魅力

在RNN的世界里,时间序列就像是一条蜿蜒的河流,处理过程相当线性且缓慢。与之相对的是,变压器通过自注意力机制,犹如一位高效的节奏指挥,使得所有元素能够迅速建立联系。通过全序列的同时处理,变压器不仅加快了计算速度,还让模型更容易捕捉长距离依赖关系。

在我们的研究中,SepFormer模型是对这一理念的完美诠释。它通过多头注意力机制,成功地在WSJ0-2mix和WSJ0-3mix数据集上取得了前所未有的表现,分别达到了22.3 dB和19.5 dB的SI-SNRi。这些数字就像是喜讯般传来,证明了无RNN架构也能在语音分离领域大展拳脚。

🛠️ SepFormer的结构解析

SepFormer的架构设计犹如一场精心编排的乐曲,由编码器、解码器和掩蔽网络三部分组成。编码器负责将输入信号转化为适合处理的格式,掩蔽网络则是它的秘密武器,负责为每位说话者生成最佳的掩蔽。最后,解码器则将分离后的信号重构回时间域。以下是该系统的高层次描述:

编码器的工作原理仿佛是一次魔术表演。它通过一个卷积层,从时间域的混合信号中学习一个STFT-like的表示。具体来说,编码器的输出可以表示为:

这一过程不仅提高了性能,还显著加快了模型的处理速度。

🎭 掩蔽网络的双重角色

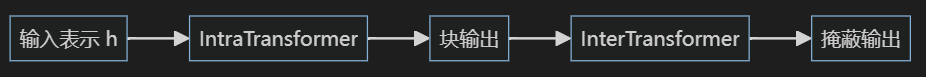

掩蔽网络是SepFormer的核心,它采用了双路径结构,分别处理短期和长期依赖。通过分块处理,掩蔽网络能够有效地学习语音信号中的复杂模式。短期依赖由IntraTransformer处理,而长期依赖则交给InterTransformer。这种双重机制确保了模型在面对复杂的音频环境时,依然能够游刃有余。

📈 性能的飞跃

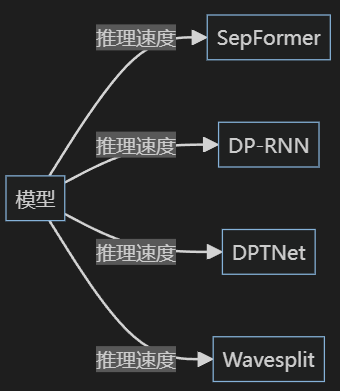

在WSJ0-2mix和WSJ0-3mix数据集上的表现,SepFormer展现了其无与伦比的能力。在各种对比实验中,SepFormer不仅超越了传统的RNN模型,还在处理速度和内存使用上表现出色。比如,在处理时间为1秒至5秒的输入时,SepFormer的推理速度和内存使用情况如下图所示:

通过将编码器的步幅设置为8,SepFormer能够显著减少计算需求,同时保持高性能输出。

🎉 结论与展望

SepFormer的出现标志着语音分离领域的一次重大突破。通过完全摆脱RNN的束缚,它展示了变压器架构在音频处理中的巨大潜力。未来,我们期待在不同的变压器架构上继续探索,以进一步提升性能、速度和内存效率。

随着技术的不断进步,SepFormer将继续在语音分离的舞台上留下浓墨重彩的一笔,助力我们在更复杂的音频环境中实现更高效的信号分离。

📖 参考文献

- Subakan, C. , Ravanelli, M., Cornell, S., Bronzi, M., & Zhong, J. (2020). Attention is all you need in speech separation.✅

- Vaswani, A. , Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention is all you need.✅

- Luo, Y. , & Mesgarani, N. (2018). TasNet: time-domain audio separation network for real-time, single-channel speech separation.✅

- Hershey, J. R., Chen, Z., Le Roux, J., & Watanabe, S. (2016). Deep clustering: Discriminative embeddings for segmentation and separation.✅

- Kolbæk, M. , Yu, D., Tan, Z. H., & Jensen, J. (2017). Multi-talker speech separation with utterance-level permutation invariant training of deep recurrent neural networks.✅

让我们一起期待SepFormer在未来的表现吧!🎤