在自然语言处理(NLP)领域,Transformer 模型已经成为了无可争议的主角。然而,尽管它们在许多任务中表现优异,却始终面临一个关键问题:如何有效地编码序列中的位置信息。传统的绝对位置编码(Absolute Position Encoding)和相对位置编码(Relative Position Encoding)方法虽然解决了部分问题,但在更复杂的任务中却显得力不从心。Meta 的 FAIR 团队提出了一种全新的方法——Contextual Position Encoding (CoPE),为这一问题提供了突破性的解决方案。

🌟 序列的秘密:为什么位置如此重要?

我们生活的世界充满了序列:从文本到代码,从音频到事件时间线,顺序信息无处不在。在文本中,单词的顺序决定了句子的意义;在代码中,语句的顺序则决定了程序的逻辑。对于 Transformer 模型来说,尽管其核心的注意力机制(Attention Mechanism)能够捕捉序列中元素之间的关系,但它本身对顺序信息是「盲」的。换句话说,Transformer 只看「内容」,而不看「位置」。

为了弥补这一缺陷,研究者们引入了位置编码(Position Encoding, PE)。PE 的核心思想是为序列中的每个位置分配一个向量,并将其添加到对应的 token 表示中,从而让模型能够感知到位置信息。

传统的 PE 方法主要分为两类:

- 绝对位置编码(Absolute PE):通过从序列起点开始计数,为每个位置分配一个固定的向量。

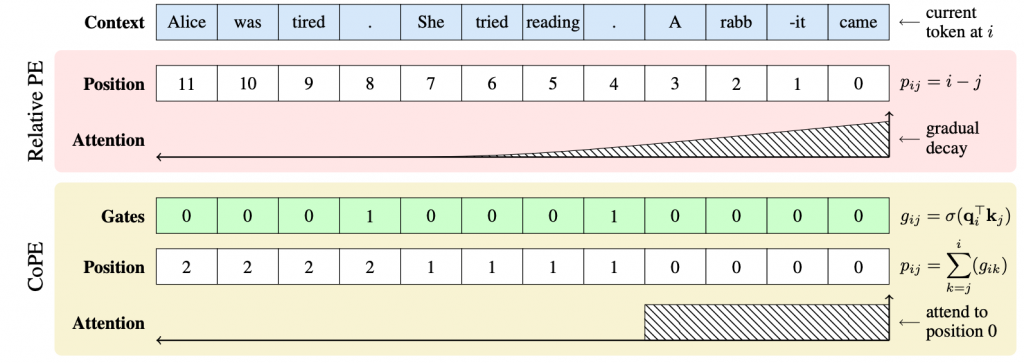

- 相对位置编码(Relative PE):根据当前 token 的位置与目标 token 的相对距离来编码。

尽管这些方法在许多任务中表现良好,但它们都基于「token 计数」这一简单的度量方式,无法处理更高层次的抽象位置(例如,第 i 个句子或第 j 个段落)。

🤔 传统方法的局限:从简单任务到复杂挑战

🧩 玩具任务中的失败

为了揭示传统位置编码方法的局限性,研究者设计了一些简单的玩具任务。例如,在一个由 y y y x y y y 组成的序列中,模型需要找到最后一个 x 的位置。然而,传统的绝对位置编码和相对位置编码在这种任务中表现不佳。原因在于,这些方法无法有效结合上下文信息,只能依赖固定的 token 位置。

更复杂的任务,例如「选择性复制任务」(Selective Copy Task),要求模型根据上下文选择性地复制某些 token。传统方法在这种任务中的表现更是惨不忍睹。

📊 数数问题:LLMs 的失误

即使是最先进的大语言模型(LLMs),如 GPT-4 和 Llama-2,在一些看似简单的任务中也会犯错。例如,当被问及「最后一句话中『Alice』这个词出现了几次」时,这些模型常常会给出错误答案。这种失败的根源在于,传统位置编码方法无法准确捕捉抽象的句子级别位置。

💡 CoPE 的创新:让位置与语境共舞

Contextual Position Encoding (CoPE) 的核心思想是将位置的定义从「固定的 token 计数」扩展到「基于语境的动态计数」。这意味着,CoPE 不仅可以编码 token 的位置,还可以编码更抽象的单位(如单词、句子或段落)的相对位置。

🔑 CoPE 的工作原理

- 门控机制(Gating Mechanism)

CoPE 首先通过计算每个 token 的查询向量(Query Vector)和键向量(Key Vector)之间的点积,生成一个「门控值」(Gate Value)。这个值决定了哪些 token 会被计入位置计算中。

数学表达式为:

$g_{ij} = \sigma(\mathbf{q}i^\top \mathbf{k}_j)$ 其中,$\sigma$ 是 sigmoid 函数,$g{ij}$ 表示 token $j$ 是否被计入 token $i$ 的位置计算。 - 累积求和(Cumulative Sum)

接下来,CoPE 对门控值进行累积求和,从而计算每个 token 的位置值:

$p_{ij} = \sum_{k=j}^i g_{ik}$

如果所有的门控值都为 1,那么 CoPE 的位置值退化为传统的相对位置。 - 插值嵌入(Interpolated Embedding)

由于 CoPE 的位置值可以是非整数,因此无法直接使用嵌入层。研究者采用了一种插值方法,将位置值映射到最近的两个整数位置的嵌入向量之间。 - 多头注意力(Multi-head Attention)

CoPE 可以与多头注意力机制无缝结合,每个注意力头可以独立计算不同的上下文位置。

🧪 实验验证:CoPE 的强大表现

为了验证 CoPE 的有效性,研究者在多个任务上进行了实验。

🔄 Flip-Flop 任务

Flip-Flop 是一种语言建模任务,旨在测试模型在长距离依赖上的表现。实验结果显示,CoPE 不仅在分布内(in-distribution)任务上表现出色,还能够很好地泛化到分布外(out-of-distribution)任务。而传统的绝对位置编码和相对位置编码在分布外任务中的表现则大幅下降。

| PE 方法 | 分布内错误率 (%) | 分布外错误率 (%) |

|---|---|---|

| 绝对位置编码 | 6.8 | 21.7 |

| 相对位置编码 | 1.8 | 20.3 |

| CoPE | 0.0 | 4.9 |

✂️ 选择性复制任务

在选择性复制任务中,CoPE 展现了惊人的鲁棒性,能够在训练数据分布之外的测试集上保持 0% 的错误率,而传统方法则完全失败。

| PE 方法 | 分布内错误率 (%) | 分布外错误率(稠密) (%) | 分布外错误率(稀疏) (%) |

|---|---|---|---|

| 绝对位置编码 | 16.9 | 25.6 | 85.2 |

| 相对位置编码 | 40.1 | 100.0 | 100.0 |

| CoPE | 0.0 | 0.0 | 0.0 |

🔢 计数任务

在计数任务中,CoPE 的表现远超传统方法,尤其是在需要泛化到更长上下文的情况下。

| PE 方法 | 变量数 1 | 变量数 3 | 变量数 5 |

|---|---|---|---|

| 绝对位置编码 | 5.3 | 67.6 | 71.5 |

| 相对位置编码 | 1.1 | 17.8 | 22.4 |

| CoPE | 0.0 | 1.2 | 7.4 |

📚 语言与代码建模:CoPE 的实际应用

在更实际的任务中,CoPE 同样表现出色。例如,在 Wikitext-103 数据集上的语言建模任务中,CoPE 显著降低了验证和测试的困惑度(Perplexity, PPL)。

| PE 方法 | 验证 PPL | 测试 PPL |

|---|---|---|

| 绝对位置编码 | 23.96 | 24.87 |

| 相对位置编码 | 22.90 | 23.81 |

| CoPE | 22.55 | 23.46 |

在代码建模任务中,CoPE 的改进更加明显,尤其是在处理更长上下文时表现出色。

🔍 未来展望:CoPE 的潜力与局限

CoPE 的提出为位置编码方法开辟了新的方向,但它也有一些局限性。例如,当前的实验主要集中在小规模模型和特定任务上,尚未在大规模模型和更广泛的基准测试中验证。此外,CoPE 的计算开销略高于传统方法,如何优化其效率仍是未来的研究方向。

尽管如此,CoPE 的潜力是巨大的。它不仅可以应用于文本和代码领域,还可能在视频、语音等其他序列数据中发挥作用。随着模型规模的扩大和任务复杂性的增加,CoPE 或许能够成为下一代位置编码方法的基石。

✨ 结语

Contextual Position Encoding (CoPE) 的提出标志着位置编码方法的一次重要突破。通过将位置与语境相结合,CoPE 不仅克服了传统方法的局限,还在多个任务中展现了卓越的性能。正如研究者所言,「位置的意义不应仅限于计数,而应是对语境的深刻理解。」